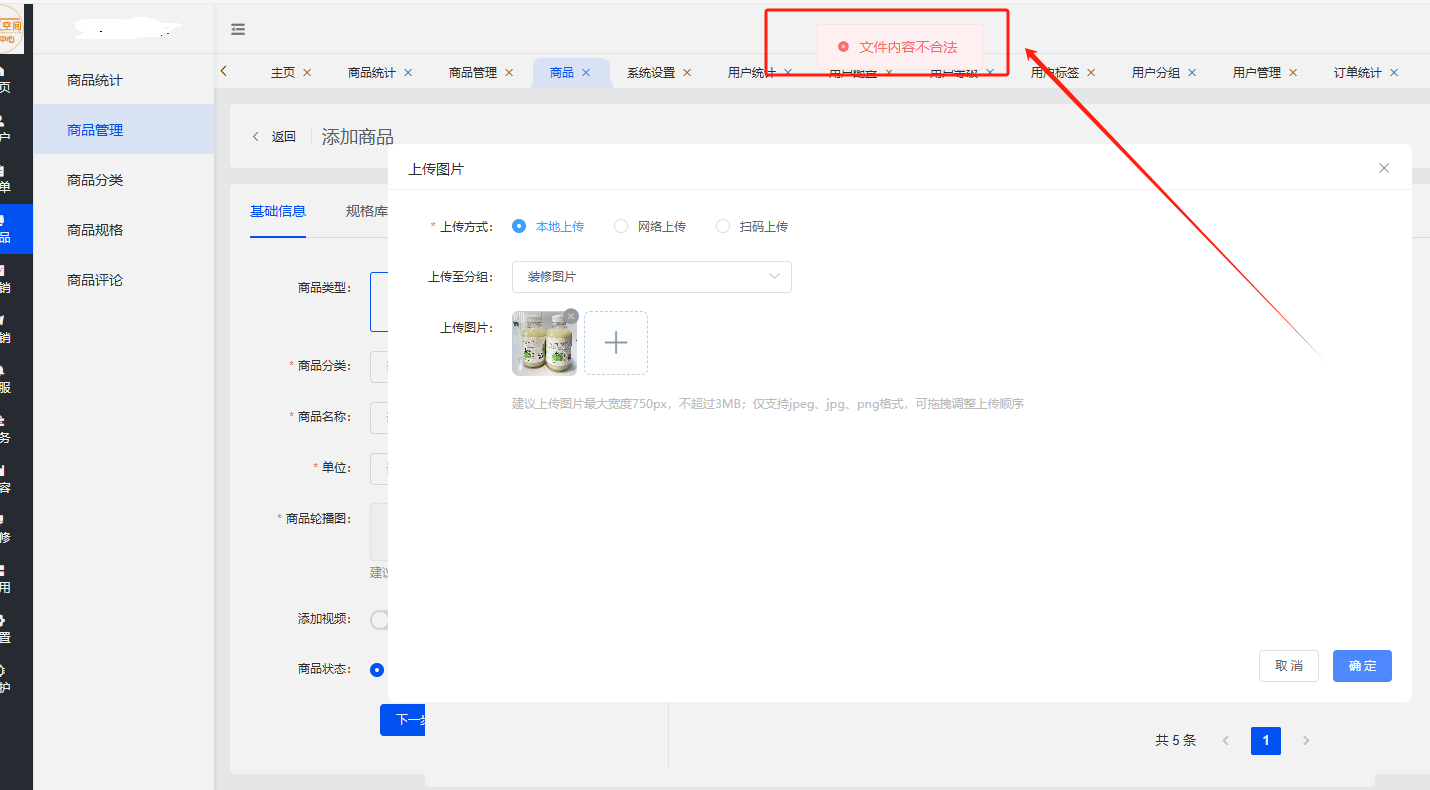

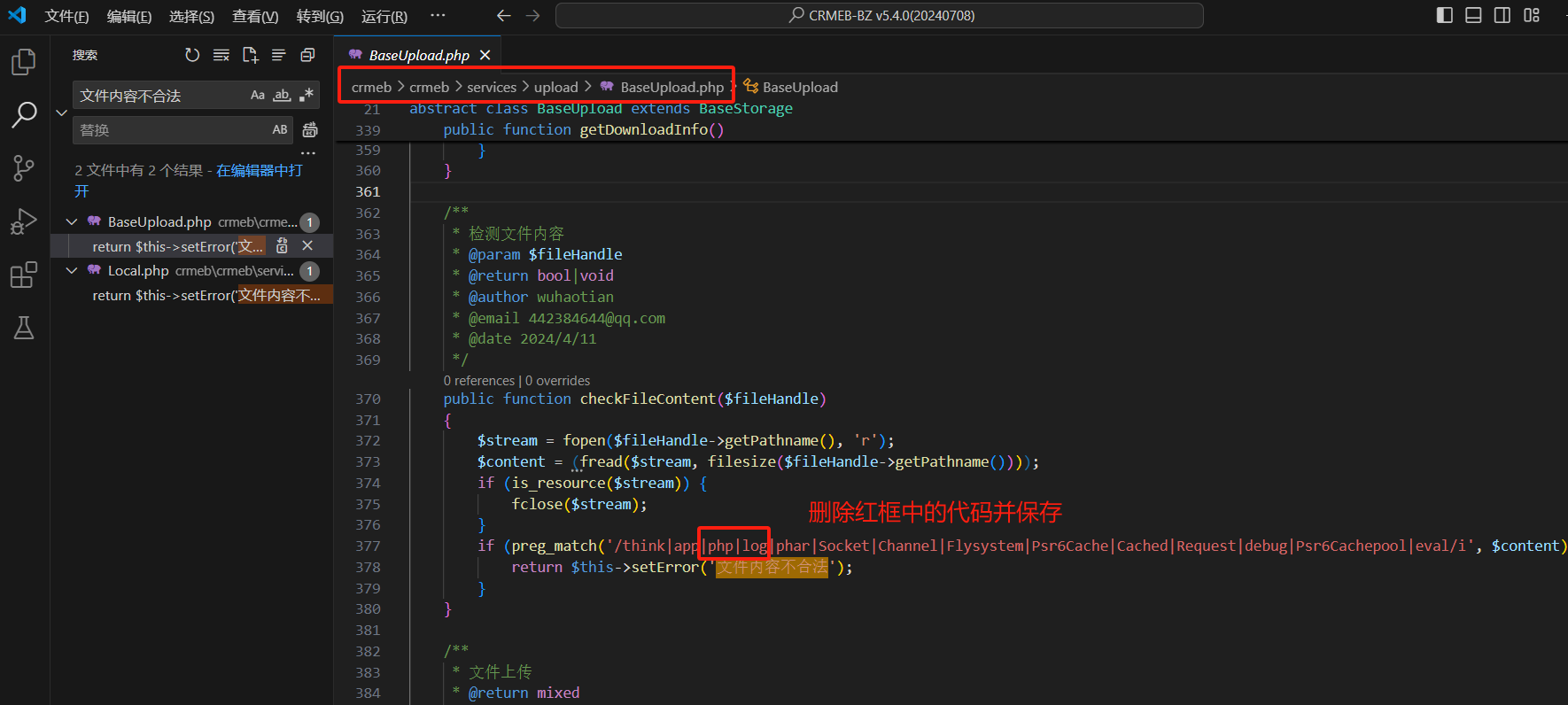

文件地址:crmeb/crmeb/services/upload/BaseUpload.php 删除红框中的|php|log

- if (preg_match('/think|app|phar|Socket|Channel|Flysystem|Psr6Cache|Cached|Request|debug|Psr6Cachepool|eval/i', $content)) {

- return $this->setError('文件内容不合法');

- }

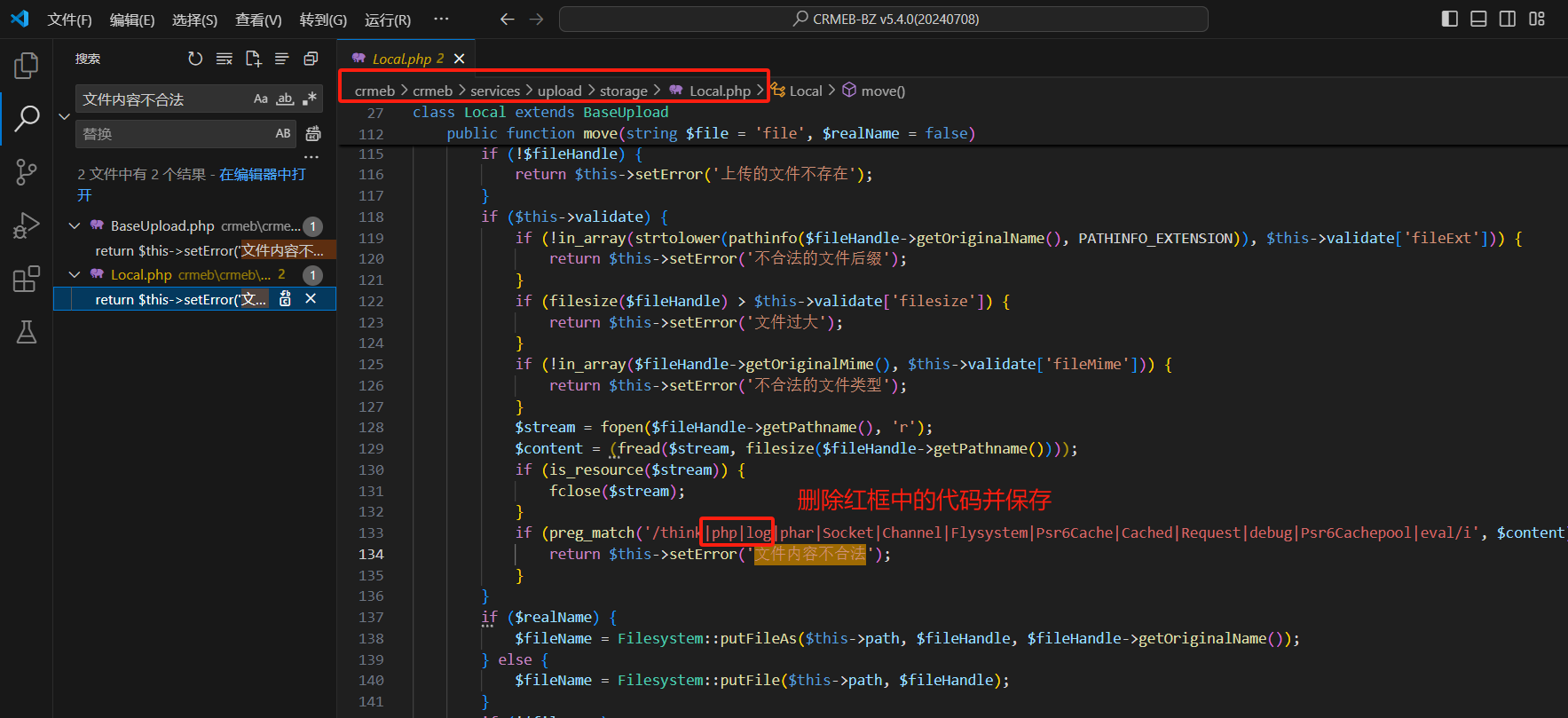

文件地址:crmeb/crmeb/services/upload/storage/Local.php 删除红框中的|php|log - if (preg_match('/think|phar|Socket|Channel|Flysystem|Psr6Cache|Cached|Request|debug|Psr6Cachepool|eval/i', $content)) {

- return $this->setError('文件内容不合法');

- }

|